-

SparkStreaming

-

SparkSQL-DataFrame

-

SparkSQL

SparkSQL

在spark内核的基础上提供了对结构化数据的处理,允许用户直接通过hive表,Parquet文件以及一些其他数据源生成的DataFrame,提高JDBC读写表的能力,可以原生支持Postgres,Mysql等系统。

在Spark1.3中,引入了DataFrame来重命名SchemaRDD类型。

-

Spark-K均值聚类

-

Spark-决策树

回归

回归是预测一个数值型数量,比如大小,收入和温度,而分类是指预测标号(label)或类别(category),比如邮件是否为垃圾邮件

分类和回归都需要从一组输入和输出中学习预测规则,属于监督学习特征

类别型特征和数值型特征,类别型特征只能在几个离散值中取一个

回归问题的目标为数值型特征,分类问题的特征是类别型特征

12.5,12,0.1,晴朗,0 为特征 所有特征的集合为训练集

-

Spark-推荐引擎

-

Spark-accumulator和broadcast

-

Spark-特殊的RDD

-

Spark-RDD

RDD

RDD(Resilient Distributed Datasets)弹性分布式数据集,是在集群应用中分享数据的一种高效,通用,容错的抽象,是Spark提供的最重要的抽象的概念,它是一种有容错机制的特殊集合,可以分布在集群的节点上,以函数式编操作集合的方式,进行各种并行操作。

-

Spark-运行内幕

运行内幕

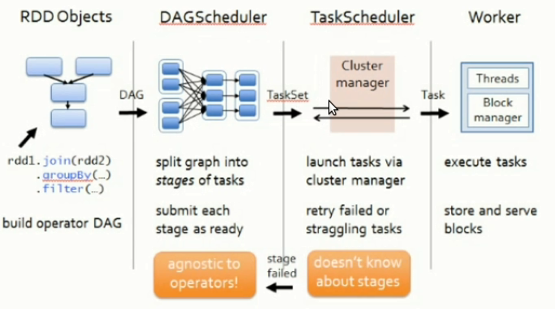

1.Driver创建DAGScheduler,TaskScheduler,在实例化过程中,注册当前程序给master,master接受注册,分配资源;一般情况下,当通过Action触发job,SparkContext会通过DAGScheduler来把job中的RDD构成的DAG划分为不同的Stage,每个Stage内部是一系列业务逻辑完全相同,处理数据不同的Tasks,构成TaskSet,而TaskScheduler和SchedulerBackend负责具体Task运行。